Cada 100 años más o menos, llega a la Tierra una tormenta solar tan potente que cubre el cielo con auroras teñidas de color rojo intenso, hace que las brújulas apunten en la dirección equivocada y produce corrientes eléctricas que atraviesan la capa superficial de nuestro planeta. La más famosa de dichas tormentas, llamada el Evento Carrington de 1859, en efecto electrocutó a operadores de telégrafo y causó que algunas oficinas se incendiaran. Un informe del año 2008, emitido por la Academia Nacional de Ciencias, advierte que si dicha tormenta ocurriera hoy en día podríamos experimentar apagones sobre grandes áreas, con diversos daños para los transformadores ubicados en puntos clave. ¿Qué es lo que tiene que hacer un operador de servicio público?

Cada 100 años más o menos, llega a la Tierra una tormenta solar tan potente que cubre el cielo con auroras teñidas de color rojo intenso, hace que las brújulas apunten en la dirección equivocada y produce corrientes eléctricas que atraviesan la capa superficial de nuestro planeta. La más famosa de dichas tormentas, llamada el Evento Carrington de 1859, en efecto electrocutó a operadores de telégrafo y causó que algunas oficinas se incendiaran. Un informe del año 2008, emitido por la Academia Nacional de Ciencias, advierte que si dicha tormenta ocurriera hoy en día podríamos experimentar apagones sobre grandes áreas, con diversos daños para los transformadores ubicados en puntos clave. ¿Qué es lo que tiene que hacer un operador de servicio público?

Un nuevo proyecto de la NASA, denominado “Escudo Solar”, podría ayudar a mantener las luces encendidas.

“Escudo Solar es un nuevo sistema de pronóstico en fase experimental para la red de energía eléctrica de América del Norte”, explica el líder del proyecto Antti Pulkkinen, quien es un investigador asociado en la Universidad Católica de América y se encuentra trabajando en el Centro Goddard para Vuelos Espaciales, de la NASA. “Creemos que podemos localizar transformadores específicos y predecir cuáles de ellos van a ser golpeados con mayor rigor por un evento ocasionado por el estado del tiempo en el espacio”.

“Escudo Solar es un nuevo sistema de pronóstico en fase experimental para la red de energía eléctrica de América del Norte”, explica el líder del proyecto Antti Pulkkinen, quien es un investigador asociado en la Universidad Católica de América y se encuentra trabajando en el Centro Goddard para Vuelos Espaciales, de la NASA. “Creemos que podemos localizar transformadores específicos y predecir cuáles de ellos van a ser golpeados con mayor rigor por un evento ocasionado por el estado del tiempo en el espacio”.

La principal causa de problemas en las redes eléctricas es la “CGI” abreviatura de “corriente geomagnética inducida” o “GIC”, por su sigla en idioma inglés. Cuando una eyección de masa coronal (una nube de tormenta solar de mil millones de toneladas) se topa con el campo magnético de la Tierra, el impacto provoca que dicho campo se sacuda y se estremezca. Estas vibraciones magnéticas inducen corrientes prácticamente en todas partes, desde la alta atmósfera terrestre hasta el suelo que yace debajo de nuestros pies. Las poderosas CGI pueden sobrecargar los circuitos, pueden dejar fuera de funcionamiento a los fusibles y, en los casos extremos, pueden derretir las bobinas de los transformadores de uso industrial.

Esto ocurrió en realidad en Quebec, el 13 de marzo de 1989, cuando una tormenta geomagnética, mucho menos severa que el Evento Carrington, dejó completamente sin electricidad a la provincia entera durante más de nueve horas. La tormenta dañó transformadores en Quebec, en Nueva Jersey y en Gran Bretaña, y causó más de 200 desperfectos eléctricos a lo ancho de Estados Unidos, desde la costa este hasta la costa noroeste del Pacífico. Una serie similar de “tormentas de Halloween“, las cuales tuvieron lugar en octubre de 2003, causó un apagón regional en el sur de Suecia y quizás pudo haber dañado algunos transformadores en Sudáfrica.

Mientras que varias empresas de servicio público han avanzado para fortalecer sus redes eléctricas, en general, la situación sólo se ha agravado. Un informe del año 2009, presentado por la Corporación de la Confiabilidad Eléctrica de América del Norte (North American Electric Reliability Corporation o NERC, por su sigla en idioma inglés) y por el Departamento de Energía de Estados Unidos, arribó a la conclusión de que los sistemas de energía modernos tienen una “creciente vulnerabilidad y exposición a los efectos de una tormenta geomagnética severa“. La razón de fondo se puede entender rápidamente observando el siguiente diagrama:

Desde el comienzo de la Era Espacial, la longitud total de las líneas eléctricas de alta tensión que atraviesan América del Norte se ha incrementado casi 10 veces. Esto ha convertido a las redes eléctricas en antenas gigantes para las corrientes inducidas geomagnéticamente. Con una demanda de energía que crece mucho más rápido que las redes mismas, las redes modernas proliferan de manera interconectada, y son llevadas al límite lo cual resulta una receta ideal para tener problemas, de acuerdo con lo que expresa la Academia Nacional de Ciencias: “La escala y la velocidad de los problemas que podrían ocurrir [en estas redes modernas] tienen el potencial de impactar en los sistemas de energía de una manera que no se ha visto con anterioridad”.

Un apagón de gran escala podría prolongarse por un largo período, principalmente debido a los daños en los transformadores. Tal y como lo apunta el informe proporcionado por la Academia Nacional: “Estos aparatos de varias toneladas de peso no se pueden reparar in situ y, si se llegaran a dañar de esta forma, tendrían que ser reemplazados por unidades nuevas que podrían demorarse en llegar hasta 12 meses o más”.

Un apagón de gran escala podría prolongarse por un largo período, principalmente debido a los daños en los transformadores. Tal y como lo apunta el informe proporcionado por la Academia Nacional: “Estos aparatos de varias toneladas de peso no se pueden reparar in situ y, si se llegaran a dañar de esta forma, tendrían que ser reemplazados por unidades nuevas que podrían demorarse en llegar hasta 12 meses o más”.

Esa es la razón por la que un pronóstico nodo por nodo de las corrientes geomagnéticas resulta potencialmente valioso. Durante las tormentas intensas, los ingenieros podrían proteger los transformadores más vulnerables desconectándolos de la red. Eso sólo provocaría un apagón, pero que sería únicamente temporal. Los transformadores que se protejan de esta forma volverían a funcionar normalmente una vez que la tormenta llegue a su fin.

Lo novedoso del Escudo Solar es su capacidad para generar predicciones vinculadas con los transformadores individuales. Pulkkinen explica cómo funciona:

“El Escudo Solar se activa cuando una eyección de masa coronal (EMC) es arrojada desde el Sol. Las imágenes proporcionadas por el satélite SOHO y por las sondas gemelas STEREO, de la NASA, nos muestran la nube de plasma desde tres puntos de vista, permitiéndonos así crear un modelo en 3 dimensiones de la EMC y predecir cuándo llegará a la Tierra”.

Mientras la EMC cruza el espacio entre la Tierra y el Sol, un recorrido que dura típicamente entre 24 y 48 horas, el equipo del Escudo Solar se prepara para calcular las corrientes de retorno por tierra. “Trabajamos en el Centro de Creación de Modelos Coordinado por la Comunidad de Goddard (Goddard’s Community Coordinated Modeling Center o CCMC, por su sigla en idioma inglés)”, dice Pulkkinen. El CCMC es un lugar donde destacados investigadores de todo el mundo han reunido sus mejores programas de computadora, basados en la física, con el fin de crear modelos de los eventos que tienen lugar en relación con el estado del tiempo en el espacio. El momento crucial tiene lugar aproximadamente 30 minutos antes del impacto, cuando la nube de plasma pasa sobre ACE, un satélite localizado a 1,5 millones de kilómetros de la Tierra. Los sensores ubicados a bordo de ACE realizan mediciones in situ de la velocidad de la EMC, así como de su densidad y de su campo magnético. Estos datos son enviados a la Tierra, al equipo del Escudo Solar que los está esperando.

“Nosotros introducimos estos datos en las computadoras del CCMC rápidamente”, relata Pulkkinen. “Nuestros modelos predicen los campos y las corrientes en la atmósfera superior y extienden estas corrientes hasta la superficie de la Tierra”. Con menos de 30 minutos de anticipación, el Escudo Solar puede emitir una alerta a las empresas de servicio público con información detallada sobre las CGI.

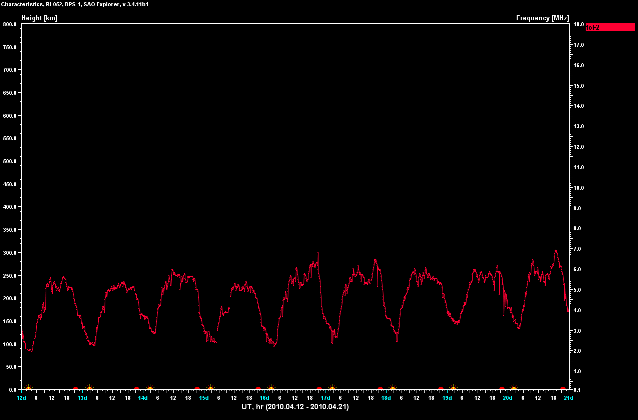

Pulkkinen hace hincapié en que el Escudo Solar se encuentra en fase experimental y en que nunca ha sido puesto a prueba durante una tormenta geomagnética severa. Un pequeño grupo de empresas de servicio público han instalado monitores de corriente en puntos clave de la red de energía con el propósito de ayudar al equipo a revisar sus predicciones. Sin embargo, hasta el momento, el Sol se ha mantenido tranquilo, en general. Sólo se observaron algunas tormentas relativamente débiles durante el año pasado. El equipo necesita más datos.

“Nos gustaría que más compañías de electricidad se unieran a nuestro esfuerzo de investigación”, añade. “Cuanto más datos podamos acumular, más rápido podremos poner a prueba y mejorar el Escudo Solar”. Las compañías de electricidad trabajan con el equipo a través del Instituto de Investigaciones sobre Energía Eléctrica (Electric Power Research Institute o EPRI, por su sigla en idioma inglés). Claro que algunas tormentas también ayudarían a poner a prueba el sistema. Y están aproximándose. Se espera que el siguiente máximo solar se produzca alrededor del año 2013, de modo que es sólo cuestión de tiempo.

Fuente: Ciencia@NASA.

24 de marzo de 2011. El Estado español dispone de un amplio sistema de redes de vigilancia radiológica medioambiental, que se compone de la Red de Vigilancia de Ámbito Nacional del Consejo de Seguridad Nuclear (CSN) y de la Red de Alerta de la Radioactividad (RAR) dependiente de la Dirección General de Protección Civil.

24 de marzo de 2011. El Estado español dispone de un amplio sistema de redes de vigilancia radiológica medioambiental, que se compone de la Red de Vigilancia de Ámbito Nacional del Consejo de Seguridad Nuclear (CSN) y de la Red de Alerta de la Radioactividad (RAR) dependiente de la Dirección General de Protección Civil.

Cada 100 años más o menos, llega a la Tierra una tormenta solar tan potente que cubre el cielo con auroras teñidas de color rojo intenso, hace que las brújulas apunten en la dirección equivocada y produce corrientes eléctricas que atraviesan la capa superficial de nuestro planeta. La más famosa de dichas tormentas, llamada el Evento Carrington de 1859, en efecto electrocutó a operadores de telégrafo y causó que algunas oficinas se incendiaran. Un informe del año 2008, emitido por la Academia Nacional de Ciencias, advierte que si dicha tormenta ocurriera hoy en día podríamos experimentar apagones sobre grandes áreas, con diversos daños para los transformadores ubicados en puntos clave. ¿Qué es lo que tiene que hacer un operador de servicio público?

Cada 100 años más o menos, llega a la Tierra una tormenta solar tan potente que cubre el cielo con auroras teñidas de color rojo intenso, hace que las brújulas apunten en la dirección equivocada y produce corrientes eléctricas que atraviesan la capa superficial de nuestro planeta. La más famosa de dichas tormentas, llamada el Evento Carrington de 1859, en efecto electrocutó a operadores de telégrafo y causó que algunas oficinas se incendiaran. Un informe del año 2008, emitido por la Academia Nacional de Ciencias, advierte que si dicha tormenta ocurriera hoy en día podríamos experimentar apagones sobre grandes áreas, con diversos daños para los transformadores ubicados en puntos clave. ¿Qué es lo que tiene que hacer un operador de servicio público? “Escudo Solar es un nuevo sistema de pronóstico en fase experimental para la red de energía eléctrica de América del Norte”, explica el líder del proyecto Antti Pulkkinen, quien es un investigador asociado en la Universidad Católica de América y se encuentra trabajando en el Centro Goddard para Vuelos Espaciales, de la NASA. “Creemos que podemos localizar transformadores específicos y predecir cuáles de ellos van a ser golpeados con mayor rigor por un evento ocasionado por el estado del tiempo en el espacio”.

“Escudo Solar es un nuevo sistema de pronóstico en fase experimental para la red de energía eléctrica de América del Norte”, explica el líder del proyecto Antti Pulkkinen, quien es un investigador asociado en la Universidad Católica de América y se encuentra trabajando en el Centro Goddard para Vuelos Espaciales, de la NASA. “Creemos que podemos localizar transformadores específicos y predecir cuáles de ellos van a ser golpeados con mayor rigor por un evento ocasionado por el estado del tiempo en el espacio”.

Un apagón de gran escala podría prolongarse por un largo período, principalmente debido a los daños en los transformadores. Tal y como lo apunta el informe proporcionado por la Academia Nacional: “Estos aparatos de varias toneladas de peso no se pueden reparar in situ y, si se llegaran a dañar de esta forma, tendrían que ser reemplazados por unidades nuevas que podrían demorarse en llegar hasta 12 meses o más”.

Un apagón de gran escala podría prolongarse por un largo período, principalmente debido a los daños en los transformadores. Tal y como lo apunta el informe proporcionado por la Academia Nacional: “Estos aparatos de varias toneladas de peso no se pueden reparar in situ y, si se llegaran a dañar de esta forma, tendrían que ser reemplazados por unidades nuevas que podrían demorarse en llegar hasta 12 meses o más”. Pueden inspeccionar chimeneas de fábricas, filmar escenas difíciles de una película o llegar allí donde los servicios de emergencia están impedidos en una catástrofe. Investigadores de la

Pueden inspeccionar chimeneas de fábricas, filmar escenas difíciles de una película o llegar allí donde los servicios de emergencia están impedidos en una catástrofe. Investigadores de la  El

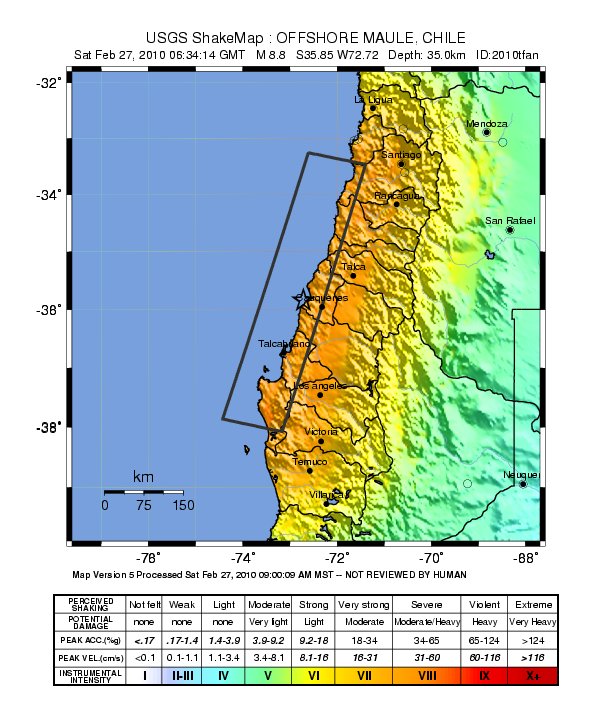

El  Los sistemas de alerta de tsunami convencionales se basan en estimaciones de la ubicación del epicentro del terremoto, su profundidad y su magnitud para determinar si se puede generar un tsunami de grandes proporciones. Sin embargo, la historia ha demostrado que la magnitud de un terremoto no es un indicador fiable del tamaño de un tsunami.

Los sistemas de alerta de tsunami convencionales se basan en estimaciones de la ubicación del epicentro del terremoto, su profundidad y su magnitud para determinar si se puede generar un tsunami de grandes proporciones. Sin embargo, la historia ha demostrado que la magnitud de un terremoto no es un indicador fiable del tamaño de un tsunami. Los recientes terremotos de Haití, Chile y China han causado miles de víctimas e inmensos daños materiales pero estas tragedias podrán en breve por lo menos reducirse con algo tan simple como un ordenador portátil. Este es el objetivo de Elizabeth Cochran, investigadora de la

Los recientes terremotos de Haití, Chile y China han causado miles de víctimas e inmensos daños materiales pero estas tragedias podrán en breve por lo menos reducirse con algo tan simple como un ordenador portátil. Este es el objetivo de Elizabeth Cochran, investigadora de la