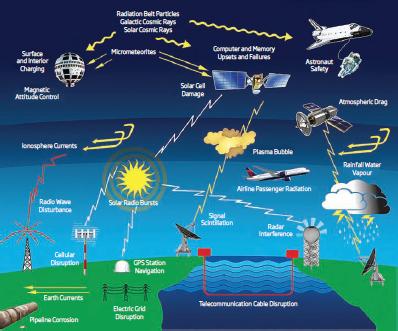

La Real Academia de Ingeniería del Reino Unido acaba de publicar en febrero de 2013 un informe titulado “Clima Espacial Extremo: Impacto en Sistemas de Ingeniería e Infraestructura”, en el que se analizan desde el punto de vista de la ingeniería los posibles impactos de una supertormenta solar en la red eléctrica, los sistemas satélite, aeronaves, sistemas de radionavegación y sistemas de radiocomunicaciones, entre otros. El informe, que se centra sobre todo en las posibles repercusiones de un evento de este tipo en el Reino Unido, puede descargarse en su versión original en inglés aquí: “Extreme Space Weather: Impact on Engineered Systems and Infrastructure”.

La Real Academia de Ingeniería del Reino Unido acaba de publicar en febrero de 2013 un informe titulado “Clima Espacial Extremo: Impacto en Sistemas de Ingeniería e Infraestructura”, en el que se analizan desde el punto de vista de la ingeniería los posibles impactos de una supertormenta solar en la red eléctrica, los sistemas satélite, aeronaves, sistemas de radionavegación y sistemas de radiocomunicaciones, entre otros. El informe, que se centra sobre todo en las posibles repercusiones de un evento de este tipo en el Reino Unido, puede descargarse en su versión original en inglés aquí: “Extreme Space Weather: Impact on Engineered Systems and Infrastructure”.

A continuación se ofrece una traducción al español de los puntos clave y de las recomendaciones que se incluyen en el resumen ejecutivo del informe.

PUNTOS CLAVE

Entorno de una supertormenta solar

Las estadísticas sobre la recurrencia de un evento de magnitud e impacto similares a un evento Carrington son escasas, aunque se están mejorando. Varios estudios consideran razonable un periodo de recurrencia de un evento de este tipo cada 100 ó 200 años y en este informe se realizan valoraciones del impacto de ingeniería basadas en un evento de esta magnitud con el citado periodo de retorno. Si estudios posteriores demuestran que pueden ocurrir eventos más severos -quizás en una escala de tiempo mayor- se debería realizar un cambio radical en las valoraciones del impacto de ingeniería. El citado periodo de 100 años no debe ser un motivo para ignorar tales riesgos.

Red eléctrica

El caso peor más razonable podría tener un impacto significativo en la red eléctrica nacional. Las simulaciones indican que alrededor de seis grandes transformadores de red en Inglaterra y Gales y otros siete transformadores en Escocia podrían quedar dañados por perturbaciones geomagnéticas y puestos fuera de servicio. El tiempo de reparación oscilaría entre semanas y meses. Adicionalmente, las estimaciones actuales indican la posibilidad de interrupciones de algunas horas en el suministro eléctrico local. Dado que la mayoría de los nodos disponen de más de un transformador, no todos estos fallos conducirían a un evento de desconexión. No obstante, el análisis de la red nacional indica que en torno a dos nodos en Gran Bretaña podrían quedar desconectados.

Satélites

Algunos satélites pueden quedar expuestos a entornos sobre los niveles de especificación típicos, incrementándose de este modo las tasas de fallos microelectrónicos y creándose riesgos de carga electroestática. Debido a la multiplicidad en el diseño de los satélites utilizados actualmente, existe bastante incertidumbre sobre el comportamiento general de la flota de satélites, aunque la experiencia adquirida durante tormentas más pequeñas indica que se puede anticipar un cierto grado de interrupción en los servicios por satélite. Afortunadamente, se espera que tanto la propia naturaleza conservadora del diseño de satélites como su diversidad limiten la escala del problema. Nuestro mejor juicio de ingeniería, basado en la tormenta de 2003, es que hasta un 10% de los satélites podrían experimentar fallos temporales con una duración comprendida entre horas y días como resultado de un evento extremo, pero es poco probable que estos fallos se extiendan uniformemente por toda la flota, dado que algunos diseños de satélites y constelaciones serán inevitablemente más vulnerables que otros. Adicionalmente, las dosis significativas de radiación acumulada podrían causar el envejecimiento rápido de muchos satélites. Los satélites muy antiguos podrían comenzar a fallar inmediatamente después de la tormenta, mientras que los más modernos sobrevivirían al evento pero con expectativas de mayores riesgos durante tormentas posteriores más moderadas. Consecuentemente, tras una tormenta extrema, todos los propietarios y operadores de satélites necesitatán evaluar cuidadosamente la necesidad de lanzar satélites de repuesto con anterioridad a sus planes iniciales, con el objetivo de mitigar el riesgo de fallos prematuros.

Seguridad de pasajeros y tripulaciones de aeronaves

Los pasajeros y las tripulaciones en vuelo durante un evento extremo podrían quedar expuestas a una dosis adicional de radiación estimada en hasta 20 mSv, valor que excede significativamente el límite anual de 1 mSv de exposiciones planificadas para el público general, siendo el triple de la dosis recibida por una persona en un escáner de pecho. Dichos niveles implican un incremento del 1 por 1000 en el riesgo de cáncer para cada persona expuesta, aunque este hecho ha de considerarse en el contexto del riesgo de cáncer durante toda su vida, que está en torno al 30%. No se espera disponer de métodos prácticos de predicción a corto plazo, dado que las partículas de alta energía más preocupantes llegan a velocidades próximas a la de la luz. Se precisan mejores métodos de monitorización a bordo de las aeronaves para mejorar tanto la mitigación como los análisis posteriores a los eventos. Se considera que un evento de este tipo generaría una preocupación considerable entre la opinión pública.

El lanzamiento de los dos primeros satélites operativos del sistema de navegación global de la UE Galileo se llevará a cabo el 20 de octubre, según ha anunciado la Comisión Europea. Esto es sólo el primero de una serie de dos lanzamientos del puerto espacial europeo de Kourou, en la Guayana Francesa.

El lanzamiento de los dos primeros satélites operativos del sistema de navegación global de la UE Galileo se llevará a cabo el 20 de octubre, según ha anunciado la Comisión Europea. Esto es sólo el primero de una serie de dos lanzamientos del puerto espacial europeo de Kourou, en la Guayana Francesa.

Rusia puso ayer en órbita, con ayuda de un cohete “Protón-M”, tres satélites que se incorporarán a su sistema de posicionamiento global GLONASS, informaron las agencias rusas.

Rusia puso ayer en órbita, con ayuda de un cohete “Protón-M”, tres satélites que se incorporarán a su sistema de posicionamiento global GLONASS, informaron las agencias rusas. Un temblor espacial es una violenta sacudida que se produce en el campo magnético terrestre. Sus efectos se sienten con más fuerza en órbita, pero también sobre la superficie de nuestro planeta. Cuando se producen, los terremotos espaciales sacuden los campos magnéticos que rodean la Tierra de la misma forma en que un terremoto sacude el suelo que pisamos. Sus efectos pueden ser medidos desde el suelo, y llegar a colapsar redes eléctricas y de telecomunicaciones.

Un temblor espacial es una violenta sacudida que se produce en el campo magnético terrestre. Sus efectos se sienten con más fuerza en órbita, pero también sobre la superficie de nuestro planeta. Cuando se producen, los terremotos espaciales sacuden los campos magnéticos que rodean la Tierra de la misma forma en que un terremoto sacude el suelo que pisamos. Sus efectos pueden ser medidos desde el suelo, y llegar a colapsar redes eléctricas y de telecomunicaciones. La acción empieza en la cola del campo magnético de la Tierra (ver vídeo), que se estira como una manga de viento bajo la acción de los continuos vientos solares. En ocasiones, la cola se estira tanto que rebota violentamente, tal y como lo haría una goma que estiráramos y después soltáramos de repente. Cuando eso sucede, el plasma solar atrapado en la cola es lanzado hacia la Tierra. Y en más de una ocasión los cinco satélites Themis estaban “en la línea de fuego” justo en el momento de producirse estos súbitos bombardeos de plasma.

La acción empieza en la cola del campo magnético de la Tierra (ver vídeo), que se estira como una manga de viento bajo la acción de los continuos vientos solares. En ocasiones, la cola se estira tanto que rebota violentamente, tal y como lo haría una goma que estiráramos y después soltáramos de repente. Cuando eso sucede, el plasma solar atrapado en la cola es lanzado hacia la Tierra. Y en más de una ocasión los cinco satélites Themis estaban “en la línea de fuego” justo en el momento de producirse estos súbitos bombardeos de plasma. Los sistemas de alerta de tsunami convencionales se basan en estimaciones de la ubicación del epicentro del terremoto, su profundidad y su magnitud para determinar si se puede generar un tsunami de grandes proporciones. Sin embargo, la historia ha demostrado que la magnitud de un terremoto no es un indicador fiable del tamaño de un tsunami.

Los sistemas de alerta de tsunami convencionales se basan en estimaciones de la ubicación del epicentro del terremoto, su profundidad y su magnitud para determinar si se puede generar un tsunami de grandes proporciones. Sin embargo, la historia ha demostrado que la magnitud de un terremoto no es un indicador fiable del tamaño de un tsunami.